Publicado origionalmente en Clavigero Núm. 17 Continuidad algorítmica Periodo: agosto – octubre 2020.

La perspectiva de la ingeniería crítica establece que entre más somos dependientes de un conjunto de tecnologías es mayor la necesidad de estudiarlas y exponer sus configuraciones.

Es posible definir la Internet desde un punto de vista canónico como un acuerdo voluntario de intercambio de paquetes entre un origen y un destino con la base del mejor esfuerzo y la ruta más económica. Este acuerdo requiere, para ser materializado, de un medio físico, software y estándares que permitan la construcción de redes interoperables.

En los años setenta se iniciaron las primeras investigaciones sobre el desarrollo de una red capaz de comunicarse de ciudad a ciudad, alrededor de los laboratorios de la RAND, DARPA, MIT y NPL.[2] Resultados de investigación que arribaron a la arquitectura de red en la que todos sus nodos serían iguales entre sí, además de poder recuperar si una parte de la misma dejara de funcionar. Una característica relevante es que esto implicaría que cada nodo tendría igual capacidad para crear, transmitir y recibir mensajes, los cuales se dividirían en paquetes.

Los estándares han tenido sus cambios y es una tarea constante que se impacta por las tensiones y las realidades, por ejemplo, la introducción de candados digitales para controlar la reproducción y copia de materiales audiovisuales en la web conocidos como extensiones de medios cifrados (EME). Estándares que van en desuso y otros que se replantean de acuerdo con nuevas necesidades y planteamientos, no siempre impulsados para el interés público o desde puntos de vista diversos.

Una de las características que se ha trastocado en los últimos años es que los diseños iniciales de los protocolos de la Internet no contaban con previsiones o planteamientos vinculados con el cuidado de la privacidad y la intimidad desde el diseño. Lo que incluso a la fecha nos pone sobre la mesa protocolos que son susceptibles de vigilancia masiva y el abuso que en los últimos años se ha denunciado, como el caso más emblemático de la Agencia Nacional de Seguridad de Estados Unidos.

Tras las revelaciones de Edward Snowden, en mayo de 2014, se concluyó en el Grupo de Trabajo de Ingeniería de Internet (IETF), en donde se estandarizan los protocolos de la Internet, que “El monitoreo generalizado es un ataque técnico que debe mitigarse en el diseño de protocolos IETF, donde sea posible”.[3] Lo anterior como resultado de un consenso entre quienes participan del diseño de los estándares de la Internet.

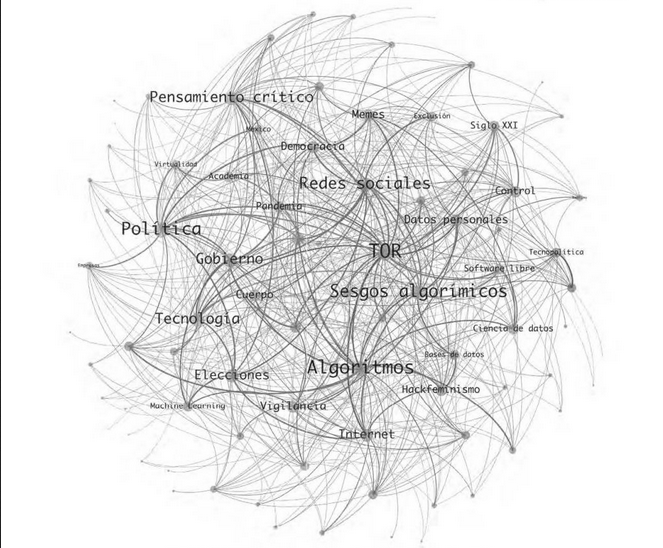

Un proyecto tecnológico que, desde 2002, se plantea aportar al ejercicio de la privacidad y el anonimato es la red Tor, una tecnología usada mundialmente que ofrece opciones a personas que quieren ejercer libertad de acceso y expresión en la Internet manteniendo su privacidad y anonimato. Para lograrlo, depende de una red de más de seis mil nodos o relevos (relays) que permiten un ruteo anónimo alrededor del mundo también llamado metafóricamente “enrutamiento cebolla”.

En México hay entre 10 mil y 15 mil usuarios y usuarias diarios, y el uso de la red Tor ha sido impulsado por la sociedad civil y colectivos. Actualmente se cuenta con 15 nodos en el país que contribuyen a la red.

La ingeniería crítica plantea que cualquier tecnología de la que dependemos representa una amenaza y una oportunidad entre ellas nuestro aprendizaje tecnopolítico.

Manifiesto de ingeniería crítica (disponible en: https://criticalengineering.org/es), como lo son las tecnologías que conforman la Internet.

Conjunto de siglas de las instituciones pioneras en la construcción de la arquitectura y los protocolos de lo que hoy es la Internet.

Véase https://tools.ietf.org/html/rfc7258